-

Analista de Sistemas

Quando eu comecei a trabalhar com computação o mercado contratava Digitadores, Programadores e Analistas de Sistemas. Os digitadores só digitavam e os programadores só programavam os sistemas especificados por um “Analista de Sistemas”. Esse era “O Cara”. Como vocês podem ver a divisão do trabalho e responsabilidades era bem diferente do que temos hoje. Hoje…

-

Comunicação Indolente

Sou extremamente entusiasmado com tecnologia e adoro até mesmo aquelas tecnologias que chegam pra quebrar tudo que já existe. Tecnologias disruptivas, na maioria das vezes, empurram a sociedade pra frente. Na terminologia usada na política eu seria chamado de “progressista”. O oposto de um “conservador”. Mas ser um progressista não deveria impedir as pessoas de…

-

A Virtude da Paciência

Eu tenho dois filhos que fazem parte das gerações Z e Alpha. Essas últimas gerações tem algumas características em comum e uma delas é a de que eles querem tudo na hora, só clicando um botão. Eles não querem profundidade. Preferem respostas rápidas. On-demand. Just in Time. Eu sou de outra geração (acho que é…

-

Bastidores de um Processo Seletivo…

… para pessoas programadoras Como sou programador eu procuro sempre ter uma abordagem voltada para solução de problemas. Mesmo quando o problema que se apresenta não seja solucionável com software. No momento que a empresa onde eu trabalhava precisou aumentar a equipe fiquei de frente com alguns problemas importantes: como encontrar e contratar profissionais com…

-

Palestrante

Hoje eu estava lendo o artigo Stepping Back from Speaking do Martin Fowler e me identifiquei com muitas coisas que ele disse. Na verdade parece um artigo que eu teria escrito para falar sobre o assunto. Exceto pelo fato dele ser “O” Martin Fowler e eu ser só o Osvaldo, eu passo (ou passava) por…

-

Código Deletado

Hoje eu vi uma pesquisa na internet onde perguntavam como eu me sentia quando via meu código sendo removido por outros desenvolvedores do meu time. A pesquisa também pedia informações de perfil profissional para tentar entender se profissionais com experiências diferentes reagiriam da mesma forma ao verem seu código removido por outro desenvolvedor do time.…

-

Meu primeiro canal: Osvaldice

Oi Pessoal, hoje eu estou aqui pra anunciar a criação do meu primeiro canal de Youtube: Osvaldice. Ele começa pequeno e ainda sem um formato bem claro mas eu pretendo colocar lá algumas reflexões que tenho e até mesmo algumas coisas da minha vida pessoal e profissional. O nome do canal é Osvaldice porque é…

-

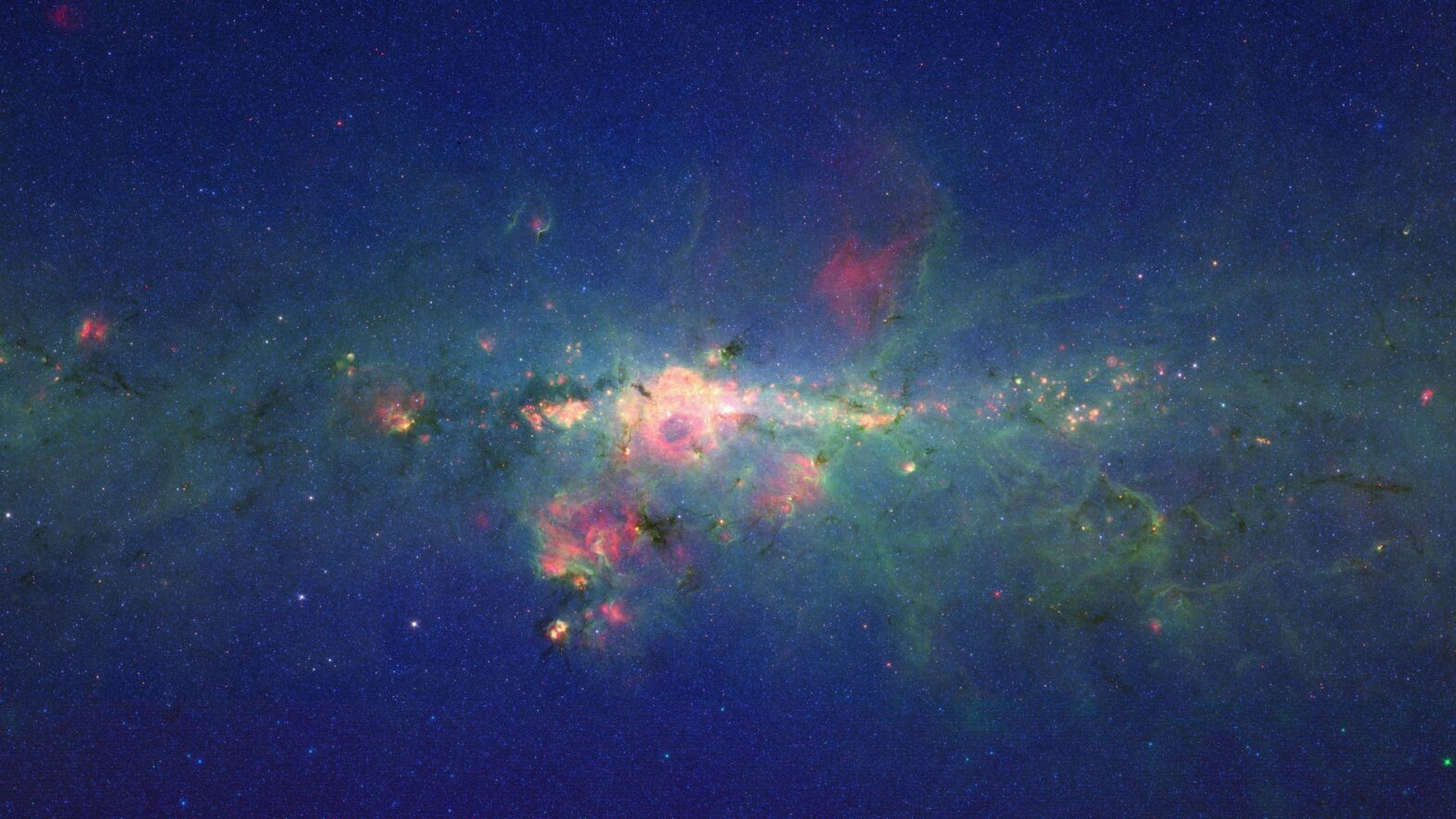

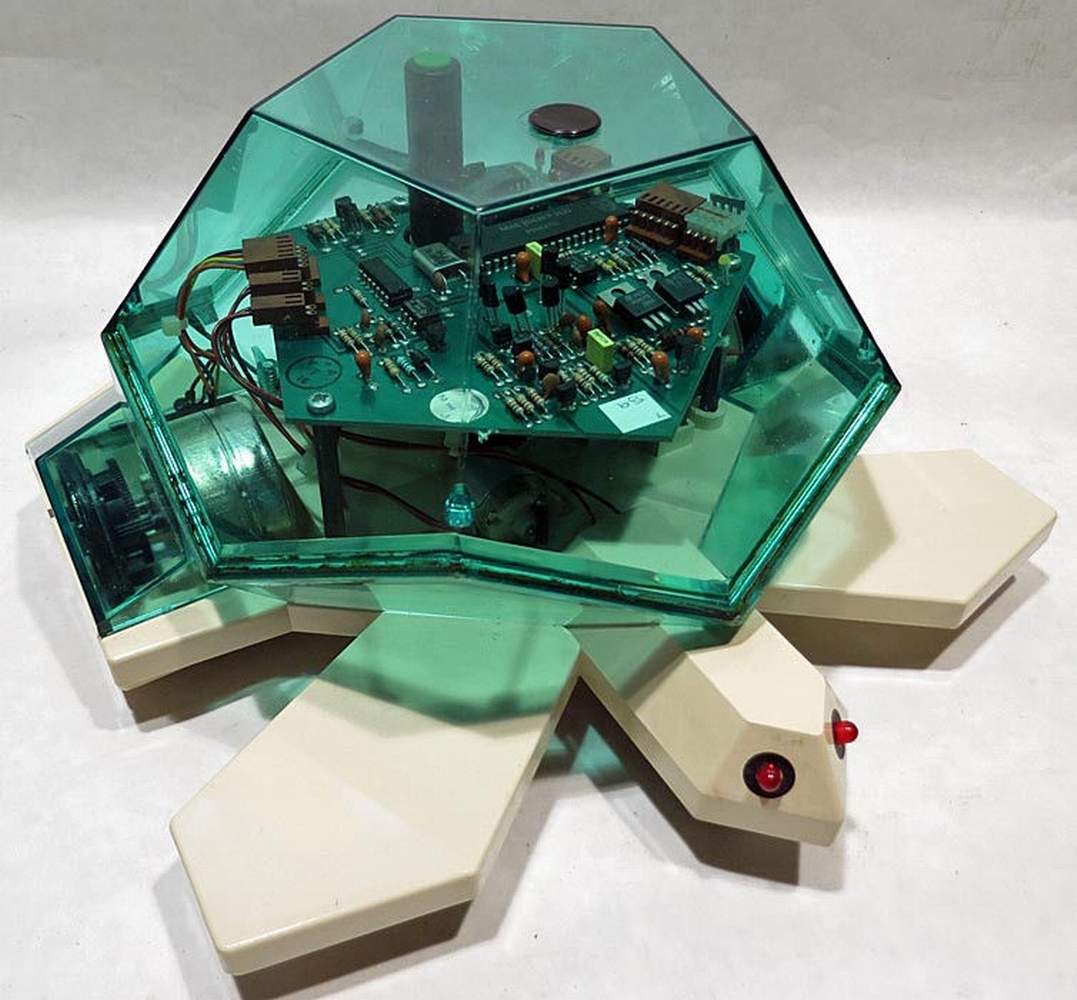

Aprendendo a Programar

Dentre vários assuntos que tenho interesse na computação um deles é sobre o aprendizado de programação. Principalmente para crianças e jovens. Já li muita coisa e ouvi opiniões muito distintas sobre as melhores formas de se ensinar e aprender a programar um computador. Existe muita discussão sobre se ensinar crianças a programar seria algo bom…

-

Pai

Me deu vontade falar do meu pai. Mas acho melhor escrever porque sempre acabo chorando quando falo dele. Não é aniversário dele nem nada. Só deu vontade mesmo. Eu me chamo Osvaldo (Neto), meu pai se chamava Osvaldo (Júnior). E meu avô, adivinhem?, chamava Osvaldo. Só Osvaldo mesmo. Pra escrever sobre meu pai eu acho…

-

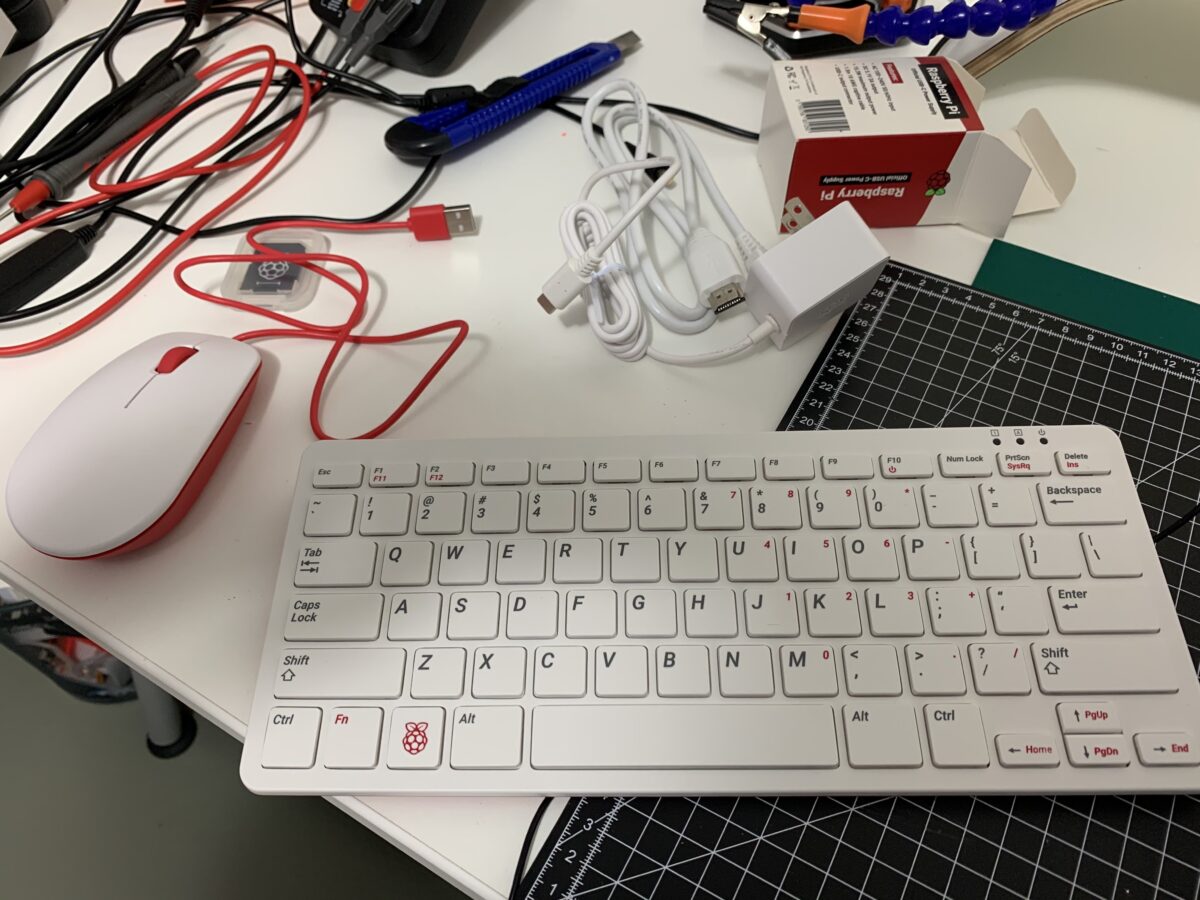

Raspberry Pi 400

No artigo anterior vocês viram que comprei um Raspberry Pi 400. Quando enviei o artigo pro meu Twitter algumas pessoas pediram um review. Então esse post aqui é uma tentativa de mostrar o computador com mais detalhes. Especificações O Raspberry Pi 400 tem as configurações muito parecidas com a do Raspberry Pi 4 Model B…

Desenvolvimento Python, Django, Carreira e Empreendedorismo